目次

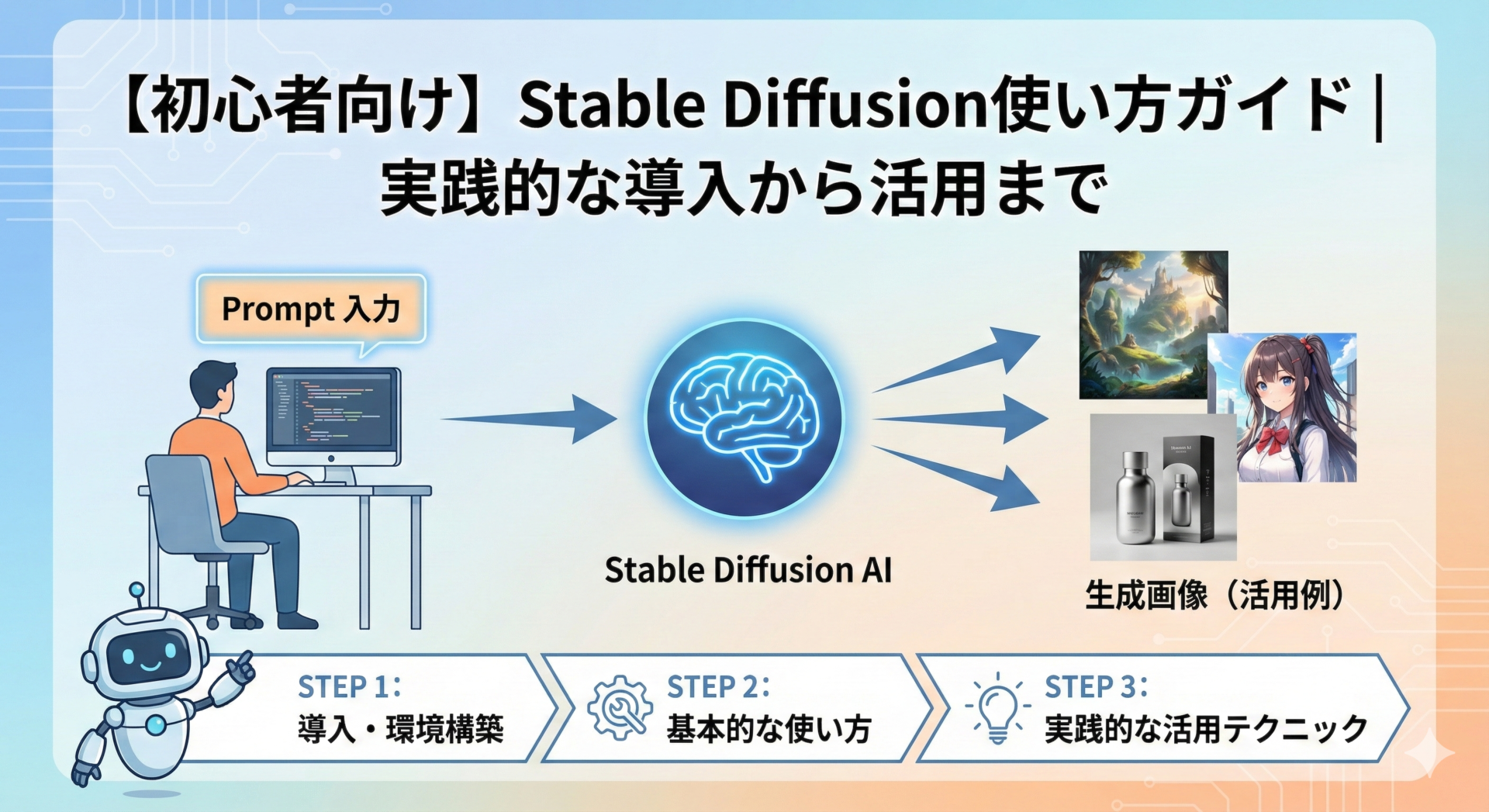

Stable Diffusionとは?画像生成AIの基礎知識

Stable Diffusionは、テキストから高品質な画像を生成できる画像生成AIです。2022年8月に公開されて以来、完全無料で商用利用も可能という特徴から、中小企業でも導入しやすいツールとして注目されています。

「拡散モデル」という技術を使い、ノイズから徐々に画像を形成する仕組みで動作します。従来プロのデザイナーに依頼していた画像制作を社内で対応できる可能性があり、素材作成の効率化やアイデア出しに活用できます。

できることと実務での活用範囲

Stable Diffusionでは、以下のような画像生成が可能です。

主な機能:

- テキストから画像生成: 「夕暮れの海辺のカフェ」といった文章から画像を作成

- 画像から画像生成: 既存画像をベースに新しいスタイルの画像を生成

- 画像の部分修正: 特定部分だけを書き換え

- 高解像度化: 低解像度画像を高品質に変換

ビジネスでの具体的な活用例:

- SNS投稿用のアイキャッチ画像

- ブログ記事やWebサイトの挿絵

- 商品イメージの試作

- プレゼン資料用のイラスト

- ECサイトの背景画像

ただし、人物の顔や手の表現、文字の生成には課題があります。あくまで素材やアイデア出しとして活用し、必要に応じて人の手で調整する前提で考えましょう。

他の画像生成AIとの比較

| 項目 | Stable Diffusion | Midjourney | DALL-E 3 |

|---|---|---|---|

| 利用料金 | 無料(ローカル) | 月額10ドル〜 | 月額20ドル〜 |

| 商用利用 | 可能 | 有料プランで可能 | 可能 |

| 導入難易度 | やや高い | 低い | 低い |

| カスタマイズ性 | 非常に高い | 低い | 低い |

Stable Diffusionの優位性:

- ローカル環境で動かせば完全無料で使い放題

- モデルの追加や設定の細かい調整が可能

- 自社サーバーで運用すれば情報が外部に送信されない

一方で、導入の手間がかかる、PCスペックが必要といったデメリットもあります。

導入前に確認すべき注意点

1. 必要なPCスペック

- GPU: NVIDIA製GPU(VRAM 6GB以上、推奨は8GB以上)

- メモリ: 16GB以上

- ストレージ: SSD 50GB以上の空き容量

2. 著作権とライセンス

- 生成した画像の著作権は基本的に利用者に帰属

- 使用したモデルのライセンスによって異なるため確認が必須

- 実在の人物や著作物を模倣した画像生成は権利侵害の可能性

3. 運用体制

- 効果的なプロンプトを書けるようになるには試行錯誤が必要

- 社内で担当者を決めて継続的に学習する体制が重要

- 生成画像には意図しない要素が含まれることがあるため、公開前に必ず人の目でチェック

導入方法の選び方|目的別3つの選択肢

Stable Diffusionを使い始めるには、大きく分けて3つの方法があります。自社の状況や目的に合わせて選択しましょう。

初心者向け:Webサービスで手軽に始める

「まずは試してみたい」という方には、Webサービス版がおすすめです。

主なWebサービス:

- Stable Diffusion Online: 完全無料、アカウント登録不要

- DreamStudio: 開発元の公式サービス、初回25クレジット無料

- Leonardo.ai: 1日150トークン無料、商用利用可能

メリット:

- PCのスペックを気にせず利用できる

- 導入の手間がかからない

- 複数のデバイスから利用可能

デメリット:

- 継続利用にはコストがかかる場合が多い

- カスタマイズの自由度が低い

- 生成枚数に制限がある

こんな方におすすめ:

- ITに詳しくない方

- 月に数十枚程度の生成で十分な方

- 初期投資を抑えたい方

本格派向け:ローカル環境への導入

「長期的に活用したい」「コストを抑えたい」という方には、ローカル環境での構築がおすすめです。

メリット:

- 完全無料で使い放題(電気代のみ)

- カスタマイズの自由度が非常に高い

- プライバシーが保護される

- 拡張機能で機能追加が可能

デメリット:

- 初期設定に時間と知識が必要

- 高スペックなPCが必要(特にGPU)

- トラブル時は自分で解決する必要がある

こんな方におすすめ:

- 月に100枚以上生成する予定の方

- カスタマイズや細かい設定にこだわりたい方

- 機密情報を含む画像を生成する方

目的別の選び方

| 判断基準 | Webサービス | ローカル環境 |

|---|---|---|

| 初期コスト | 無料〜 | 0円(PC代除く) |

| 月額コスト | 0〜50ドル | 0円(電気代のみ) |

| 導入難易度 | ★☆☆☆☆ | ★★★★☆ |

| 推奨利用量 | 月50枚まで | 制限なし |

段階的な導入アプローチ:

- 第1段階(1〜2週間): Webサービスで基本操作を習得

- 第2段階(1ヶ月): 実務に試験導入し効果を確認

- 第3段階(2〜3ヶ月): 必要に応じてローカル環境を構築

このように段階的に進めることで、リスクを最小限に抑えながら自社に最適な方法を見つけることができます。

ローカル環境への導入手順

ここからは、AUTOMATIC1111版Web UIを使った具体的な導入手順を解説します。

必要な環境とツールの準備

推奨スペック:

- GPU: NVIDIA GeForce RTX 3060(VRAM 12GB)以上

- CPU: Intel Core i7以上

- メモリ: 32GB以上

- ストレージ: SSD 100GB以上の空き容量

- OS: Windows 10/11(64bit)

必要なソフトウェア:

- Python 3.10.6: プログラミング言語の実行環境

- Git: バージョン管理ツール

- CUDA Toolkit: NVIDIA GPU用のライブラリ

各ソフトウェアのインストール時は、Pythonでは**「Add Python to PATH」に必ずチェック**を入れてください。

Web UIのインストール

手順1: インストール先フォルダの作成

Cドライブ直下に「stable-diffusion」フォルダを作成します。日本語や空白を含まないパスにすることが重要です。

手順2: Web UIのダウンロード

コマンドプロンプトを開き、以下を実行:

cd C:\stable-diffusion

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

手順3: 初回起動

cd stable-diffusion-webui

webui-user.bat

初回は必要なパッケージが自動でインストールされます(10〜30分程度)。

手順4: ブラウザでアクセス

ブラウザで「http://127.0.0.1:7860」にアクセスし、Web UIの画面が表示されれば成功です。

よくあるエラーと対処法:

- 「CUDA out of memory」:

webui-user.batにset COMMANDLINE_ARGS=--medvramを追加 - 「Python was not found」: Pythonを再インストールし、パスを通す

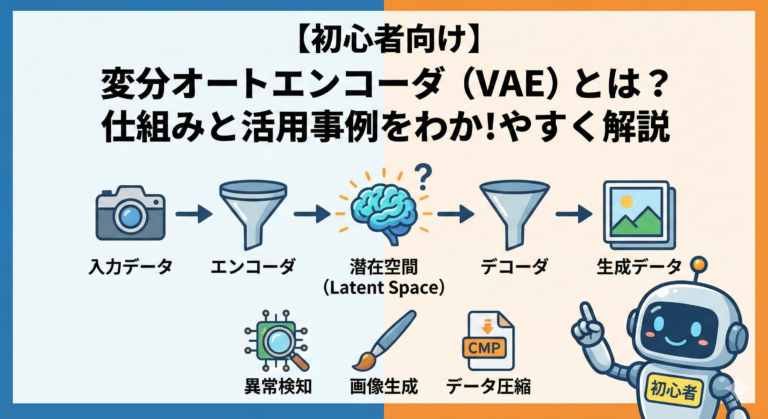

モデルのダウンロードと設定

モデルは画像生成の「脳」にあたる部分です。異なるモデルで生成される画像のスタイルや品質が変わります。

おすすめの初心者向けモデル:

- Stable Diffusion v1.5: あらゆる画像生成に対応する汎用モデル

- Stable Diffusion XL: より高品質な画像生成(要高スペックPC)

- Anything V5: アニメ・イラスト風の画像生成

モデルの設置手順:

- Hugging FaceまたはCivitaiからモデルファイルをダウンロード

stable-diffusion-webui\models\Stable-diffusion\フォルダに移動- Web UIを再起動してモデルを選択

モデルファイルは1つあたり2GB〜7GB程度の容量があるため、ストレージ容量に注意しましょう。

基本的な使い方|画像生成の実践

プロンプトの書き方の基本

プロンプトは「画像生成の指示書」です。効果的なプロンプトには一定のパターンがあります。

基本的な構文:

[主題] [詳細な説明] [スタイル] [品質指定]

具体例:

a cat, sitting on a wooden table, warm sunlight,

professional photography, highly detailed, 8k

効果的なプロンプトのコツ:

- 具体的な単語を使う(「動物」より「猫」)

- 英語で入力する(日本語も可能だが精度が下がる)

- カンマで要素を区切る

- 品質を上げるキーワードを追加(highly detailed, 8k, high quality)

ネガティブプロンプトで品質を高める

ネガティブプロンプトは「生成してほしくない要素」を指定する機能です。

基本的なネガティブプロンプト:

low quality, blurry, pixelated, bad anatomy,

deformed, ugly, watermark, text

用途別の推奨ネガティブプロンプト:

- 人物画像: bad hands, extra fingers, deformed face

- 風景画像: oversaturated, unnatural colors

- 商品画像: cluttered background, distracting elements

生成パラメータの調整

主要なパラメータ:

Steps(ステップ数): 20〜30が目安

- 少ない: 生成が速いが品質が低い

- 多い: 品質が上がるが時間がかかる

CFG Scale(プロンプトへの忠実度): 7〜12が目安

- 低い: 自由な解釈、意外な結果

- 高い: プロンプトに忠実、硬い表現

Sampling method(サンプリング方法): 初心者は「DPM++ 2M Karras」がおすすめ

Seed(シード値):

- -1: ランダム生成

- 固定値: 同じ画像を再現

初心者向け推奨設定

汎用的な設定:

- Steps: 25

- CFG Scale: 7

- Sampling method: DPM++ 2M Karras

- Width × Height: 512×512(最初は小さめで試す)

この設定で数枚生成し、結果を見ながら調整していきましょう。

実務での活用テクニック

ビジネス用途別プロンプトのパターン

商品イメージ画像:

[商品の種類] on wooden table, warm morning light,

professional product photography, clean background,

high quality, 8k

バナー・広告素材:

[メインビジュアル] centered composition,

bright and energetic colors, simple background,

commercial use, high contrast

SNS投稿用画像:

[テーマ] lifestyle photography, cozy and relaxing,

instagram style, natural colors, soft lighting

作業効率を上げる便利な機能

1. Img2Img(画像から画像を生成)

既存の画像をベースに新しい画像を生成します。

実務での活用例:

- 商品写真の背景だけを変更

- ラフスケッチから完成イメージを作成

- 写真を特定のスタイルに変換

使い方:

- 「img2img」タブを選択

- 元となる画像をアップロード

- プロンプトで変更内容を指定

- Denoising strength(0.4〜0.6が目安)を調整

2. Batch処理(一括生成)

同じ設定で複数枚を一度に生成します。

- Batch count: 生成を繰り返す回数

- Batch size: 1回で同時生成する枚数

A/Bテスト用の複数パターン生成や、素材ストックの作成に活用できます。

3. Styles(スタイル保存)

よく使うプロンプトをスタイルとして保存できます。

スタイル名: 商品写真用

プロンプト: professional product photography,

studio lighting, clean white background,

high quality, 8k

保存したスタイルはドロップダウンから選択するだけで適用できます。

生成画像の管理方法

効果的な管理方法:

フォルダ構造の設計:

📁 stable-diffusion-outputs/

📁 商品画像/

📁 バナー素材/

📁 SNS投稿用/

📁 テスト生成/

ファイル名のルール化:

[日付]_[用途]_[内容]_[バージョン].png

例: 20240115_banner_spring_v01.png

メタデータの活用:

Web UIの「PNG Info」タブに画像をドラッグすると、使用したプロンプトとパラメータが表示されます。「Send to txt2img」で同じ設定を再現できます。

バックアップ体制:

- 採用した画像は必ずクラウドストレージにバックアップ

- 月1回は完全バックアップを実施

- 重要なプロジェクトは複数箇所に保管

商用利用時の注意点

ライセンスの確認:

- Stable Diffusion本体は商用利用可能

- モデルによってライセンスが異なるため必ず確認

- Hugging FaceやCivitaiのモデルページで「License」を確認

主なライセンスタイプ:

- CreativeML OpenRAIL-M: 商用利用可能、標準的なライセンス

- CC BY-NC 4.0: 非商用のみ(商用利用不可)

- 独自ライセンス: 個別に確認が必要

避けるべきケース:

- 有名人の顔を学習したモデル

- アニメキャラクターを学習したモデル

- 特定のアーティストのスタイルを学習したモデル

商用利用のチェックリスト:

- 使用モデルのライセンスを確認した

- 商用利用が明示的に許可されている

- 既存作品との類似性をチェックした

- 実在の人物・キャラクターに似ていない

- 企業ロゴや商標が含まれていない

生成画像は「素材」として扱い、人の手で加工・編集することで創作性を加えるのが安全です。

中小企業の導入ポイント

導入前に明確にすべきこと

Stable Diffusion導入で失敗する最大の原因は、「何のために使うか」が明確でないことです。

導入前に答えるべき3つの質問:

1. どの業務プロセスで使うのか?

- 新商品のイメージビジュアル作成

- SNS投稿用の画像素材作成

- Webサイトのバナー画像作成

2. 誰が使うのか?

- マーケティング担当者(デザイン経験なし)

- 広報担当者(基本的なPC操作は可能)

3. 何を改善したいのか?

- 外注費を月3万円削減

- 画像制作時間を50%短縮

- SNS投稿頻度を週1回から週3回に増加

業務フロー整理の例:

現状(SNS投稿画像の作成):

1. 投稿内容の企画(30分)

2. 無料素材サイトで画像検索(30分)

3. Canvaで加工(20分)

合計: 約80分

導入後:

1. 投稿内容の企画(30分)

2. プロンプトで画像生成(10分)

3. Canvaで加工(15分)

合計: 約55分(30%削減)

社内で定着させる運用設計

段階的な学習プログラム:

Week 1: 基本操作の習得

- Web UIの起動方法

- 簡単なプロンプトでの画像生成

- 目標: 1日10枚生成できる

Week 2: プロンプトの理解

- 効果的なキーワードの学習

- Negative promptの活用

- 目標: 意図した画像を3回に1回は生成できる

Week 3: 実務での活用

- 実際の業務で使用

- 用途別プロンプトテンプレートの活用

- 目標: 実務で使える画像を生成できる

すぐ使えるテンプレート集の整備:

【商品写真用テンプレート】

プロンプト: [商品名] on white background,

professional product photography, studio lighting,

high quality, 8k

ネガティブ: low quality, blurry, cluttered background

【SNS投稿用テンプレート】

プロンプト: [テーマ] lifestyle photography,

warm and cozy, instagram style, natural lighting

ネガティブ: oversaturated, unnatural, low quality

よくある失敗パターンと対策

失敗パターン1: 「とりあえず導入」で使われなくなる

→ 対策: 具体的な用途と目標を設定してから導入

失敗パターン2: 属人化して特定の人しか使えない

→ 対策: マニュアルを作成し、複数人で学習

失敗パターン3: 期待した品質が出ず諦める

→ 対策: 「素材」として活用し、人の手で調整する前提で運用

外部パートナーに相談すべきタイミング

以下のような場合は、外部の専門家に相談することをおすすめします。

- 社内にIT担当者がいない

- 導入したが使いこなせない

- カスタマイズや拡張機能を活用したい

- 業務フロー全体の見直しが必要

Harmonic Societyでは、AI活用の計画づくりから社内定着まで伴走サポートを提供しています。「ちょうどいい」デジタル化を一緒に実現しませんか?

まとめ|まずは小さく始めて徐々に活用を広げる

Stable Diffusionは、中小企業でも活用できる強力な画像生成ツールです。この記事のポイントを振り返りましょう。

重要なポイント:

- Stable Diffusionは無料で商用利用可能な画像生成AI

- 導入方法は「Webサービス」「ローカル環境」から選択

- プロンプトの書き方で生成される画像の品質が大きく変わる

- 商用利用時はモデルのライセンスを必ず確認

- 「何のために使うか」を明確にしてから導入する

推奨する導入ステップ:

- 第1段階: Webサービスで無料体験(1〜2週間)

- 第2段階: 実務で試験導入し効果を検証(1ヶ月)

- 第3段階: 本格運用と最適化(2〜3ヶ月)

Stable Diffusionは「完璧な画像を自動生成する魔法の道具」ではありません。しかし、適切に活用すれば、画像制作の効率化やコスト削減に大きく貢献します。

まずは小さく始めて、自社に合った使い方を見つけていきましょう。

業務の仕組み化で困ったときは:

Harmonic Societyでは、AI導入コンサルティングから社内定着まで伴走サポートを提供しています。「ちょうどいい」デジタル化を実現するために、まずはお気軽にご相談ください。