目次

「ChatGPTって便利だけど、これってどういう仕組みなんだろう?」「うちの会社でも使えないかな?」

最近、ニュースやSNSで「LLM」や「大規模言語モデル」という言葉を目にする機会が増えました。ChatGPTをはじめとする生成AIの急速な普及により、中小企業の経営者の方々からも「自社の業務に活用できないか」というご相談をいただくことが増えています。

しかし、「LLM とは何か」を正確に理解している方は、まだ多くありません。「AIが文章を書いてくれる便利なツール」という認識だけでは、自社のビジネスに最適な形で活用することは難しいでしょう。

この記事では、LLM(大規模言語モデル)の仕組みを初心者の方にもわかりやすく解説し、中小企業での具体的な活用方法までご紹介します。専門用語はできるだけ避け、「なぜ今LLMが注目されているのか」「自社の業務効率化にどう役立つのか」といった実践的な視点でお伝えしていきます。

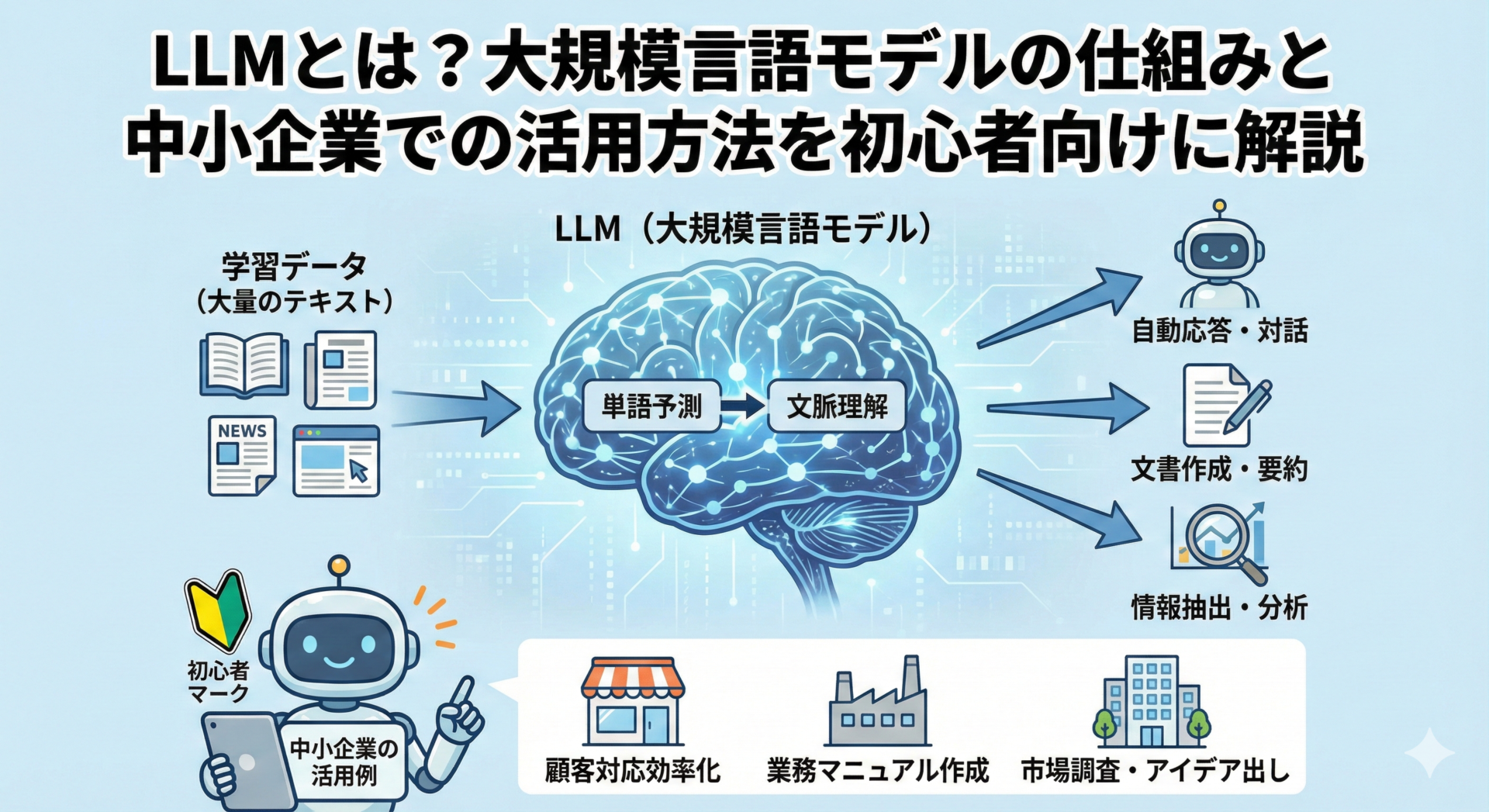

LLM(大規模言語モデル)とは?基本をわかりやすく解説

LLM(Large Language Model:大規模言語モデル)とは、膨大なテキストデータを学習し、人間のような自然な文章を生成できるAI技術のことです。ChatGPTやGeminiなど、最近話題の生成AIサービスの中核を担う技術として、ビジネスシーンでも急速に注目を集めています。

「大規模言語モデル」という言葉だけを聞くと難しく感じるかもしれませんが、その本質は「言葉のパターンを大量に学んだAI」と考えるとわかりやすいでしょう。

LLMの定義と「大規模」の意味

LLMの「大規模(Large)」には、主に2つの意味があります。

1. 学習データの規模

LLMは、インターネット上の書籍、ウェブサイト、論文など、数千億から数兆もの単語を含む膨大なテキストデータから学習しています。例えばGPT-3は、約45TB(本にすると数百万冊分)のテキストデータから学習しており、この学習データの量が従来のAIとは桁違いに多いことが特徴です。

2. モデルのパラメータ数

もう一つの「大規模」は、モデルの複雑さを表す「パラメータ」の数です。パラメータとは、AIが学習によって調整する内部の設定値のようなもので、最新のLLMでは数千億から数兆個のパラメータを持っています。このパラメータ数が多いほど、より複雑な言語パターンを理解し、精度の高い文章を生成できます。

従来の言語処理AIは特定の用途(翻訳、要約など)に特化して開発されていましたが、LLMは一つのモデルで文章生成、翻訳、要約、質問応答など、多様なタスクをこなせる汎用性を持っています。

生成AIとLLMの関係性

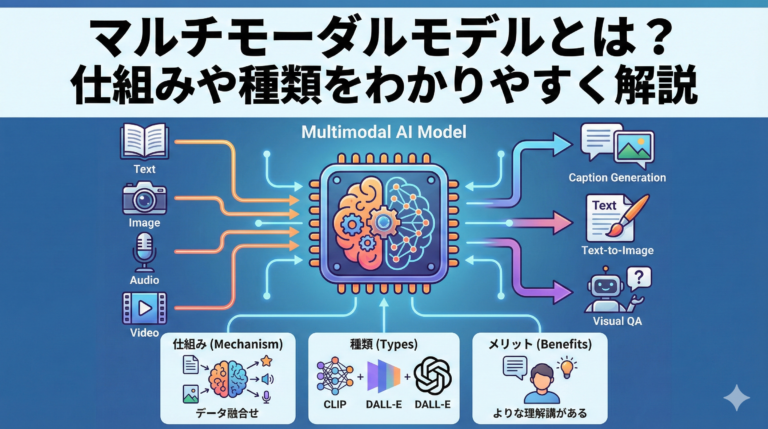

「生成AI」と「LLM」という言葉は、しばしば混同されますが、正確には異なる概念です。

**生成AI(Generative AI)**は、テキスト、画像、音声、動画など、新しいコンテンツを生成できるAI技術の総称です。一方、LLM とは生成AIの一種であり、特にテキスト生成に特化した技術を指します。

つまり、生成AIという大分類の中に、LLM(テキスト生成)、画像生成AI(Stable Diffusion、Midjourneyなど)、音声生成AI、動画生成AIなどが含まれる関係です。

LLMは生成AIの中でも最も実用化が進んでおり、ChatGPTの登場により**「誰でも使える生成AI」として一気に普及しました。また、最近ではマルチモーダルLLM**と呼ばれる、テキストだけでなく画像や音声も理解できるモデルも登場しています。

身近なLLMの例と特徴

すでに多くの方が日常的に使っているサービスの裏側で、LLMが動いています。

ChatGPT(OpenAI)

最も有名なLLM活用サービスで、GPTシリーズ(GPT-3.5、GPT-4など)を使用しています。対話形式で質問に答えたり、文章を生成したりでき、無料版と有料版があり、中小企業でも導入しやすい価格設定が特徴です。

Gemini(Google)

Googleが開発したLLMで、Google検索やGoogleドキュメントとの連携が強みです。最新情報へのアクセスや、Google Workspaceとの統合活用が可能です。

Claude(Anthropic)

安全性と正確性を重視して開発されたLLMです。長文の処理が得意で、契約書や報告書などのビジネス文書の分析に適しています。日本語にも対応しており、丁寧で正確な回答が特徴です。

Copilot(Microsoft)

MicrosoftがOpenAIと提携して提供するサービスで、GPT-4ベースのLLMを使用しています。Microsoft 365との統合が進んでおり、既存の業務フローに組み込みやすいのが中小企業にとってのメリットです。

これらのサービスは、すべて基本的には同じ「LLM」という技術をベースにしていますが、それぞれ特徴や得意分野が異なります。自社の業務内容や既存のツール環境に合わせて選ぶことが重要です。

なぜ今LLMが注目されているのか

LLM自体は2018年頃から研究が進んでいましたが、2022年末のChatGPT登場を機に爆発的に注目されるようになりました。

1. 誰でも使える形で提供されたこと

従来のAI技術は専門知識がなければ使いこなせませんでしたが、ChatGPTは普通の言葉で話しかけるだけで使えるという革新的なインターフェースを実現しました。プログラミング知識がなくても、経営者自身が直接使って価値を実感できることが、普及の大きな要因です。

2. 業務効率化の即効性

メール作成、議事録作成、資料の要約など、日常業務の多くをLLMがサポートできます。導入した翌日から効果を実感できる即効性が、「とりあえず試してみよう」という動きを加速させています。

3. コストの劇的な低下

数年前まで、高度な言語処理AIを使うには数百万円の投資が必要でした。しかし現在は、月額数千円から数万円で、最先端のLLMを利用できるようになりました。この価格破壊が、中小企業での導入を現実的なものにしています。

4. 人手不足への対応策として

日本の中小企業は深刻な人手不足に直面しています。LLMは、人を雇わずに業務処理能力を拡張できる手段として期待されています。完全に人に代わるわけではありませんが、定型的な作業を任せることで、既存スタッフがより付加価値の高い業務に集中できるようになります。

LLMの仕組み:どうやって人間のような文章を生成するのか

「なぜAIが人間のような文章を書けるのか?」——LLMの仕組みを理解することで、何ができて何ができないのか、どこまで信頼できるのかを正しく判断できるようになります。

ディープラーニングと自然言語処理の基礎

LLMを支える2つの基礎技術について説明します。

**ディープラーニング(深層学習)は、人間の脳の神経回路を模倣した「ニューラルネットワーク」という仕組みを使って、データからパターンを学習する技術です。わかりやすく例えると、「大量の例を見せることで、AIが自分でルールを見つける」**という学習方法です。

**自然言語処理(NLP)**は、人間が日常的に使う言葉(自然言語)をコンピュータに理解させる技術です。コンピュータは本来、0と1の数字しか理解できませんが、NLP技術によって、文章の意味を解析したり、適切な返答を生成したりできるようになります。

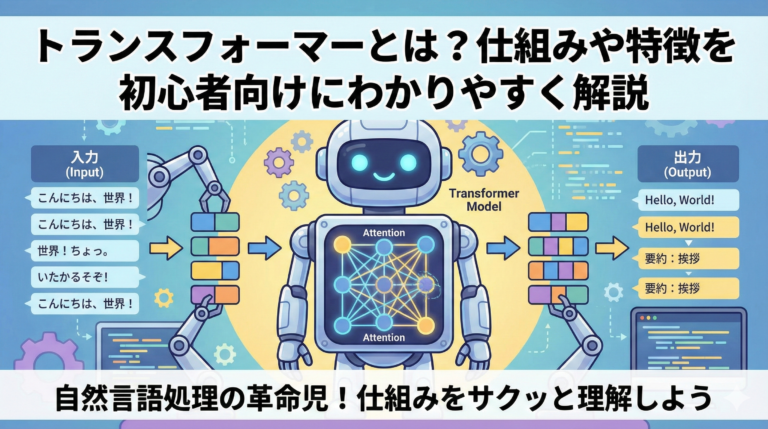

LLMは、このディープラーニングと自然言語処理を組み合わせた技術です。特に、2017年に登場した「Transformer(トランスフォーマー)」というアーキテクチャが飛躍的な進歩を支えました。これは、文章の中で「どの単語とどの単語が関連しているか」を効率的に学習できる仕組みで、長い文章でも文脈を正確に理解できるようになりました。

学習データとパラメータの役割

LLMがどのように「賢く」なるのかを理解するには、「学習データ」と「パラメータ」という2つの要素を知る必要があります。

学習データ:AIの教科書

学習データとは、LLMが学習するための「教材」です。書籍、論文、ニュース記事、ウェブサイト、Wikipediaなど、数千億から数兆もの単語を含むテキストデータから、言葉の使い方、文章の構造、知識、推論のパターンなどを学んでいます。

ただし、ここで重要なのは、LLMは「暗記」しているわけではないということです。個別の文章を丸覚えしているのではなく、言葉の「パターン」や「関係性」を抽出して学習しています。

パラメータ:AIの記憶容量

パラメータとは、学習によって調整される「重み」のようなものです。人間の脳で言えば、神経細胞のつながりの強さに相当します。一般的に、パラメータ数が多いほど、より複雑なパターンを学習でき、高精度な文章生成が可能になります。

- GPT-2:15億パラメータ(2019年)

- GPT-3:1,750億パラメータ(2020年)

- GPT-4:推定1兆パラメータ以上(2023年)

ただし、パラメータが多ければ良いというわけではありません。計算コストが高くなり、処理速度が遅くなるというトレードオフもあります。

「次の単語を予測する」仕組みの解説

LLMの文章生成の本質は、実はとてもシンプルです。それは**「次に来る単語を予測する」**という作業の繰り返しなのです。

例えば、「今日は天気が」という文章があったとき、LLMは次に来る可能性が高い単語を予測します:

- 「良い」:確率50%

- 「悪い」:確率30%

- 「不安定」:確率15%

- その他:確率5%

この確率分布から一つを選び、文章に追加します。そして、「今日は天気が良い」という新しい文章に対して、また次の単語を予測する……これを繰り返すことで、長い文章を生成していきます。

LLMが優れているのは**「文脈を考慮して予測する」**点です。直前の単語だけでなく、文章全体の流れや意味を理解して予測します。これがTransformerの「注意機構(Attention)」と呼ばれる仕組みで、文章の中で重要な部分に注目して判断できるようになっています。

同じ質問をしても、毎回少し違う回答が返ってくることに気づいたことはありませんか?これは、LLMが確率に基づいて単語を選んでいるためです。ある程度ランダム性を持たせることで、自然で多様な表現が可能になっています。

ここで注意すべきは、LLMは**「意味を理解している」わけではない**ということです。あくまで統計的なパターンに基づいて、次に来る単語を予測しているだけです。この違いが、LLMの限界にもつながっています。

LLMができることとできないこと

LLMを業務に活用する前に、その能力と限界を正しく理解することが非常に重要です。

LLMが得意なこと

- 文章の生成・執筆:メール文面、報告書、議事録、商品説明文、ブログ記事など

- 要約・整理:長文の要約、会議の議事録整理、複数の情報源からのポイント抽出

- 翻訳・言い換え:多言語翻訳、専門用語の平易な言い換え、文体の変換

- 質問応答:一般的な知識に関する質問、社内マニュアルに基づく回答

- アイデア出し:企画のアイデア提案、問題解決の選択肢提示

LLMが苦手・できないこと

- 最新情報の提供:学習データの時点以降の情報は持っていない(※一部のLLMはWeb検索機能で補完)

- 正確な計算や数値処理:複雑な数式の計算は間違えることがある

- 事実の検証:もっともらしい嘘(ハルシネーション)を生成することがある

- 創造的な独自性:既存のパターンの組み合わせは得意だが、完全にオリジナルな発想は難しい

- 感情や倫理的判断:感情を「理解」しているわけではない

適切な活用のポイント

LLMを効果的に活用するには、**「人とAIの協働」**という視点が重要です。LLMは「下書き」や「たたき台」を作る役割を担い、最終的な判断と責任は人間が持つ。定型的な業務はLLMに任せ、人間は創造的な業務に集中する。このバランスが、中小企業にとって最も現実的で効果的なアプローチです。

LLMの種類と代表的なモデル

LLMは、提供形態によって「オープンソース型」と「クローズド型」に大きく分けられます。それぞれにメリット・デメリットがあり、企業規模や用途によって適切な選択が変わります。

オープンソース型とクローズド型の違い

クローズド型(プロプライエタリ)LLM

企業が独自に開発し、APIやサービスとして提供するLLMです。代表例は、GPT-4(OpenAI)、Claude(Anthropic)、Gemini(Google)などです。

メリット:高性能で精度が高い、セキュリティやコンプライアンスが整備されている、サポート体制が充実、すぐに使い始められる

デメリット:利用料金が発生する、カスタマイズの自由度が低い、ベンダーロックインのリスク

オープンソース型LLM

モデルの構造や重みが公開されており、誰でも自由に使用・改変できるLLMです。代表例は、LLaMA(Meta)、Mistral、日本語特化型(ELYZA、Swallowなど)です。

メリット:基本的に無料で使用できる、自社サーバーで運用可能(データが外部に出ない)、カスタマイズや独自学習が可能

デメリット:導入に技術的な知識が必要、サーバーやGPUなどのインフラコストがかかる、サポートは基本的にコミュニティ頼み

多くの中小企業にとっては、まずクローズド型から始めることをおすすめします。初期投資が少なく、すぐに効果を実感できるためです。業務での活用が定着し、より高度なカスタマイズが必要になった段階で、オープンソース型の検討を始めるのが現実的です。

代表的なLLMの特徴

GPTシリーズ(OpenAI)

最も有名で利用者が多いLLMで、文章生成が得意です。GPT-3.5は無料版ChatGPTで使用され高速・低コスト、GPT-4は有料版で使用されより高精度です。文章作成、カスタマーサポート、アイデア出し、コード生成など幅広い用途に対応し、API経由で自社システムに組み込むことも可能です。

Claude(Anthropic)

安全性と正確性を重視した設計で、長文の処理が得意(最大10万トークン)です。Claude 3シリーズには、Haiku(高速・低コスト)、Sonnet(バランス型)、Opus(最高性能)があり、契約書分析、長文レポートの要約、詳細な調査・分析業務に適しています。

Gemini(Google)

Google検索との連携が強みで、最新情報へのアクセスが可能です。Google Workspaceとの統合により、ドキュメント作成やスプレッドシート分析などの業務効率化に活用できます。

日本語対応LLMの現状と選び方

海外製のLLMは英語での学習データが中心のため、日本語での精度が若干劣る場合があります。しかし、GPT-4やClaude 3などの最新モデルは日本語性能も大幅に向上しており、ビジネス利用には十分な品質です。

日本企業が開発した日本語特化LLMも登場していますが、現時点では海外製の最新モデルの方が総合的な性能は高い傾向にあります。

中小企業が選ぶべきLLMの基準

- 用途に合った機能:文章生成重視ならGPT、長文分析ならClaude

- 既存ツールとの連携:Microsoft 365ならCopilot、Google WorkspaceならGemini

- コスト:まずは無料版から試し、効果を実感してから有料版へ

- サポート体制:日本語サポートの有無、導入支援の充実度

- セキュリティ:機密情報を扱う場合は、データの取り扱いポリシーを確認

中小企業でのLLM活用事例:業務効率化の実例

LLMは、中小企業の様々な業務で実際に成果を上げています。ここでは、具体的な活用事例を紹介します。

文書作成・メール対応の自動化

活用例

- 営業メールの下書き作成(顧客情報を入力すると、適切な提案文を生成)

- 議事録の自動生成(会議の音声を文字起こし後、LLMで整理・要約)

- 報告書のたたき台作成(箇条書きのメモから、体裁の整った報告書を生成)

- 社内文書の校正・リライト(わかりにくい文章を平易な表現に変換)

効果

- 文章作成時間が30〜50%短縮

- 表現の質が均一化

- 担当者の心理的負担が軽減

顧客対応・問い合わせ対応の効率化

活用例

- FAQの自動応答(よくある質問に対して、LLMが適切な回答を提示)

- 問い合わせ内容の分類・振り分け(受信したメールを内容に応じて自動分類)

- 対応履歴の要約(過去のやり取りを自動的に要約し、引き継ぎを容易に)

- 初回対応の下書き作成(問い合わせ内容から、適切な返信文の下書きを生成)

効果

- 初回対応時間が40〜60%短縮

- 対応品質の均一化

- 担当者の負担軽減により、複雑な案件に集中できる

社内ナレッジの整理と検索

活用例

- 社内文書の自然言語検索(「〇〇の手順を教えて」と質問すると、関連文書から情報を抽出)

- マニュアルの自動生成(業務手順をヒアリングし、マニュアルのたたき台を作成)

- 過去の事例検索(「類似案件の対応方法は?」と質問すると、過去事例を提示)

- 暗黙知の形式知化(ベテラン社員のノウハウをインタビューし、文書化)

効果

- 情報検索時間が50〜70%短縮

- 新人教育期間の短縮

- 属人化の解消

Excel管理からの脱却とデータ活用

活用例

- データの自然言語分析(「先月の売上トップ5を教えて」と質問すると、データを分析して回答)

- レポートの自動生成(数値データから、グラフ付きの分析レポートを生成)

- データクレンジング(表記ゆれや重複データを自動的に整理)

- 予測分析の補助(過去データから傾向を分析し、今後の予測を提示)

効果

- データ分析時間が30〜50%短縮

- 非専門家でもデータ活用が可能に

- 意思決定の質と速度が向上

LLM導入で失敗しないための3つのポイント

「LLMを導入したいけれど、また失敗したらどうしよう…」——適切なステップと現実的な期待値設定があれば、LLMは中小企業にとって強力な武器になります。

「何でもできる」という期待値を調整する

LLMに関する情報を見ると、「業務が劇的に変わる」といった言葉が並びますが、万能ではありません。

特に重要なのは、**LLMは「人の代わり」ではなく「人のサポート役」**という認識です。メールの下書きは作れても、最終的な文面の判断は人間が行う。顧客対応の候補案は出せても、実際の対応判断は担当者が行う。この「ちょうどいい役割分担」を最初から意識することで、過度な期待による失望を避けられます。

現実的な効果の目安

- 文章作成業務:30〜50%の時間短縮

- 情報整理業務:40〜60%の効率化

- 顧客対応業務:初回対応の20〜30%を自動化

- 完全な人員削減:現実的ではない

小さく始めて段階的に広げる

多くの失敗事例に共通するのは、最初から大きく始めすぎることです。「全社で一斉に導入」「すべての業務をLLM化」といったアプローチは、混乱を招き、結果的に誰も使わなくなります。

成功する導入ステップ

- パイロット運用(1〜2ヶ月):1つの部署または1つの業務から開始、3〜5名程度の少人数で試験運用

- 改善と調整(1ヶ月):パイロット運用で見えた課題を解決、プロンプトの最適化、マニュアル整備

- 段階的展開(2〜3ヶ月):成功した部署の事例を社内共有、他部署へ順次展開

- 全社定着(継続):定期的な勉強会や情報共有、新しい活用方法の発見と展開

例えば、最初は「営業部のメール作成支援」だけに絞り、効果が実感できたら「カスタマーサポートの問い合わせ対応」へ展開、さらに「総務部の文書作成」へと広げていく。このように成功を積み重ねるアプローチが、中小企業には最適です。

自社の業務フローを理解してから導入する

「とりあえずChatGPTを契約してみた」という企業は多いですが、実際に使いこなせているケースは限られます。その理由は、自社の業務とLLMの接点が明確でないからです。

導入前に整理すべきこと

- 時間がかかっている業務の洗い出し:各部署で「時間がかかる業務トップ3」をリストアップ

- 業務の性質の分類:定型的か非定型的か、判断基準が明確か曖昧か、頻度は高いか低いか

- LLM活用の可能性を検討:文章作成要素があるか、パターン化できる部分があるか

- 優先順位の決定:効果が大きく、導入しやすい業務から着手

このような業務分析は、一見面倒に思えるかもしれません。しかし、この工程こそが成功の鍵です。自社の業務を理解せずにツールを導入しても、「使える場面」が見つからず、結局使われなくなります。

ITに詳しくなくても大丈夫な理由

「LLMを使いこなすには、プログラミングの知識が必要なのでは?」と不安に思う経営者もいらっしゃいますが、基本的な活用に専門知識は不要です。

ChatGPTのような対話型インターフェースは、普段の会話のように指示を出すだけで使えます。つまり、ITスキルよりも「自社の業務を理解している」ことの方が重要なのです。技術的な部分は、パートナー企業がサポートできます。

LLMを活用した「ちょうどいい仕組みづくり」とは

「既製品のSaaSは機能が多すぎて使いこなせない」「かといってフルカスタム開発は予算的に無理」——多くの中小企業が、このジレンマに悩んでいます。しかし今、LLMの登場によって、**その中間にある「ちょうどいい選択肢」**が現実的になってきました。

既製品SaaSとカスタム開発の間にある選択肢

従来、中小企業がITシステムを導入する際の選択肢は、大きく2つでした。既製品SaaSは機能が多すぎて使いこなせず、月額料金が積み重なる一方、フルカスタム開発は初期費用が数百万円〜で開発期間も数ヶ月かかり、中小企業の予算では現実的ではありませんでした。

LLMを活用した「第三の選択肢」

LLMとモダン開発手法を組み合わせることで、必要な機能だけを持つシステムを、短期間・低コストで構築できるようになりました。

特徴

- 開発費用:従来の1/3〜1/2(AIがコード生成をサポート)

- 開発期間:1〜3週間〜2ヶ月(最小構成から段階的に拡張)

- 必要な機能だけを実装(無駄がない)

- 自社の業務フローに完全に合わせられる

- 後から機能追加が容易

価格帯のイメージ

- 最小構成(1〜2機能):30万円〜50万円

- 標準構成(3〜5機能):50万円〜100万円

- 複数機能統合:100万円〜200万円

従来のフルカスタム開発が300万円〜500万円だったことを考えると、中小企業でも手が届く価格帯になっています。

LLMを組み込んだ業務システムの可能性

LLMは単体で使うだけでなく、業務システムに組み込むことで真価を発揮します。

顧客管理(CRM)× LLM

「〇〇社との契約内容を教えて」と質問するだけで情報取得、過去のメールや商談記録から重要情報を自動抽出、「次回提案すべき内容」をAIが提案します。営業担当者の引き継ぎが容易になり、新人でもベテラン並みの情報アクセスが可能になります。

社内ナレッジベース × LLM

「〇〇の手順を教えて」と聞くだけで回答、社内文書から自動的に情報を抽出、質問に対して関連情報も提示します。新人教育期間の短縮、ベテラン社員への質問集中を解消、暗黙知の形式知化が実現できます。

予約・問い合わせ管理 × LLM

問い合わせ内容の自動分類、定型的な質問への自動応答、過去の類似事例を自動提示、対応内容の自動要約・記録が可能です。対応時間の大幅短縮、対応品質の均一化、担当者の負担軽減が実現できます。

見積・請求システム × LLM

「〇〇向けの見積を作って」で自動生成、過去の類似案件から適切な価格を提案、見積書の文面を自動で最適化します。見積作成時間の大幅短縮、価格設定の標準化、提案品質の向上が実現できます。

属人化を防ぎ、引き継ぎやすい仕組みへ

中小企業の多くが抱える深刻な課題が業務の属人化です。「あの人しか分からない」「担当者が休むと業務が止まる」という状況は、企業の成長を妨げます。

LLMによる属人化解消のアプローチ

- 暗黙知の形式知化:ベテラン社員の判断基準をLLMに学習させる

- 業務手順の自動ガイド:業務の流れをLLMが対話形式で案内

- 引き継ぎ資料の自動生成:業務記録から引き継ぎ資料を自動作成

- 標準化と柔軟性の両立:基本的な流れは標準化し、個別対応はLLMがサポート

重要なのは、完全な自動化を目指すのではなく、「誰でも一定レベルの業務ができる」状態を作ることです。LLMは、そのための強力なサポート役になります。

中小企業に寄り添う開発パートナーの選び方

LLMを活用したシステム開発を検討する際、パートナー選びが成功の鍵を握ります。

良いパートナーの条件

- 中小企業の事情を理解している:予算の制約を理解し、段階的な導入を提案

- 業務理解から始めてくれる:いきなり技術の話をせず、現場の声を丁寧にヒアリング

- 専門用語を使わず説明できる:ITに詳しくない人にも分かる言葉で話す

- 導入後もサポートしてくれる:作って終わりではなく、運用フェーズも伴走

- 実績と事例がある:同規模の企業での実績、具体的な成果が示せる

Harmonic Societyの特徴

私たちは「テクノロジーと人間性の調和」を理念に、中小企業に寄り添うパートナーであることを大切にしています。

- 千葉県を中心とした地域密着:対面でのコミュニケーションも可能

- 小さな一歩から伴走:無理のない範囲でスタート

- AI活用で低コスト実現:従来の1/3〜1/2の開発費用

- 導入後も継続サポート:運用フェーズも一緒に改善

- 200社以上の経営者との対話実績:中小企業の課題を深く理解

「こんなこと相談してもいいのかな?」という小さな疑問からで構いません。まずはお気軽にお話を聞かせてください。一緒に「ちょうどいい仕組み」を考えていきましょう。

まとめ:LLMは中小企業の味方になる技術

LLMの基本と仕組みのおさらい

LLM(大規模言語モデル)とは、大量のテキストデータから学習したAIで、人間のような自然な文章を生成・理解できる技術です。ChatGPTなど、すでに多くの人が使っている技術で、文章の作成・要約・校正、情報の整理・分類、定型業務のサポートが得意です。

一方で、最新情報の提供、複雑な計算、責任を伴う最終判断、独創的なクリエイティビティは苦手です。人とAIの協働を基本とし、LLMは「サポート役」として活用し、最終判断は人間が行うことが重要です。

中小企業こそLLMを活用すべき理由

「LLMは大企業のもの」と思っていませんか?実は、中小企業こそLLMの恩恵を受けやすいのです。

理由1:少人数だからこそ効率化の効果が大きい

一人が複数の役割を担う中小企業では、業務効率化の効果が直接的です。1人あたりの生産性向上が、会社全体の成果に直結し、限られたリソースを最大限に活用できます。

理由2:意思決定が早く、導入がスムーズ

大企業のような複雑な承認プロセスが不要で、トライ&エラーがしやすく、効果が見えたらすぐに展開できます。

理由3:コストパフォーマンスが高い

月額数千円から始められ、人を雇うよりも圧倒的に低コストです。効果が実感できてから投資を拡大できます。

理由4:競合との差別化になる

中小企業でLLMを活用している企業はまだ少数です。今始めることで、競合に対する優位性を築けます。業務効率化により、価格競争力や提案スピードで差をつけられます。

まずは相談から始めてみませんか

「うちの会社でも使えるかな?」「何から始めればいいんだろう?」——そんな疑問や不安をお持ちの経営者の方、まずは気軽にご相談ください。

Harmonic Societyでは、無料の初回相談を実施しています。御社の業務内容をお聞きし、LLM活用の可能性を一緒に考えます。押し売りは一切ありません。「今はまだ早い」という結論になることもあります。それでも構いません。

初回相談でお話しすること

- 現在の業務で困っていること

- LLM活用の可能性がある業務

- 導入する場合の現実的なステップ

- 費用感と期待できる効果

- 他社の成功事例・失敗事例

LLMは、中小企業の味方になる技術です。大企業だけのものではありません。あなたの会社にも、必ず活用できる場面があります。

「テクノロジーと人間性の調和」を理念に、私たちは中小企業の皆様に寄り添います。一緒に、御社にとって「ちょうどいい仕組み」を作っていきましょう。